Proprio ora, NVIDIA ha rilasciato il chip AI più potente al mondo.

L’intelligenza artificiale generativa ha raggiunto un punto critico.

La conferenza GTC 2024, durata due ore, è stata più simile a un concerto su larga scala. Jim Fan, uno scienziato senior di NVIDIA, ha scherzato dicendo che "Jensen Huang è il nuovo Taylor Swift".

Questa è probabilmente l'attuale posizione di Jen-Hsun Huang di Nvidia nel settore dell'intelligenza artificiale.

L'anno scorso, Huang Renxun affermò che il "momento iPhone" dell'intelligenza artificiale era arrivato, permettendoci di vedere come la vita quotidiana viene riscritta dall'intelligenza artificiale, e oggi dimostra che la velocità di questo cambiamento sta accelerando in modo pazzesco.

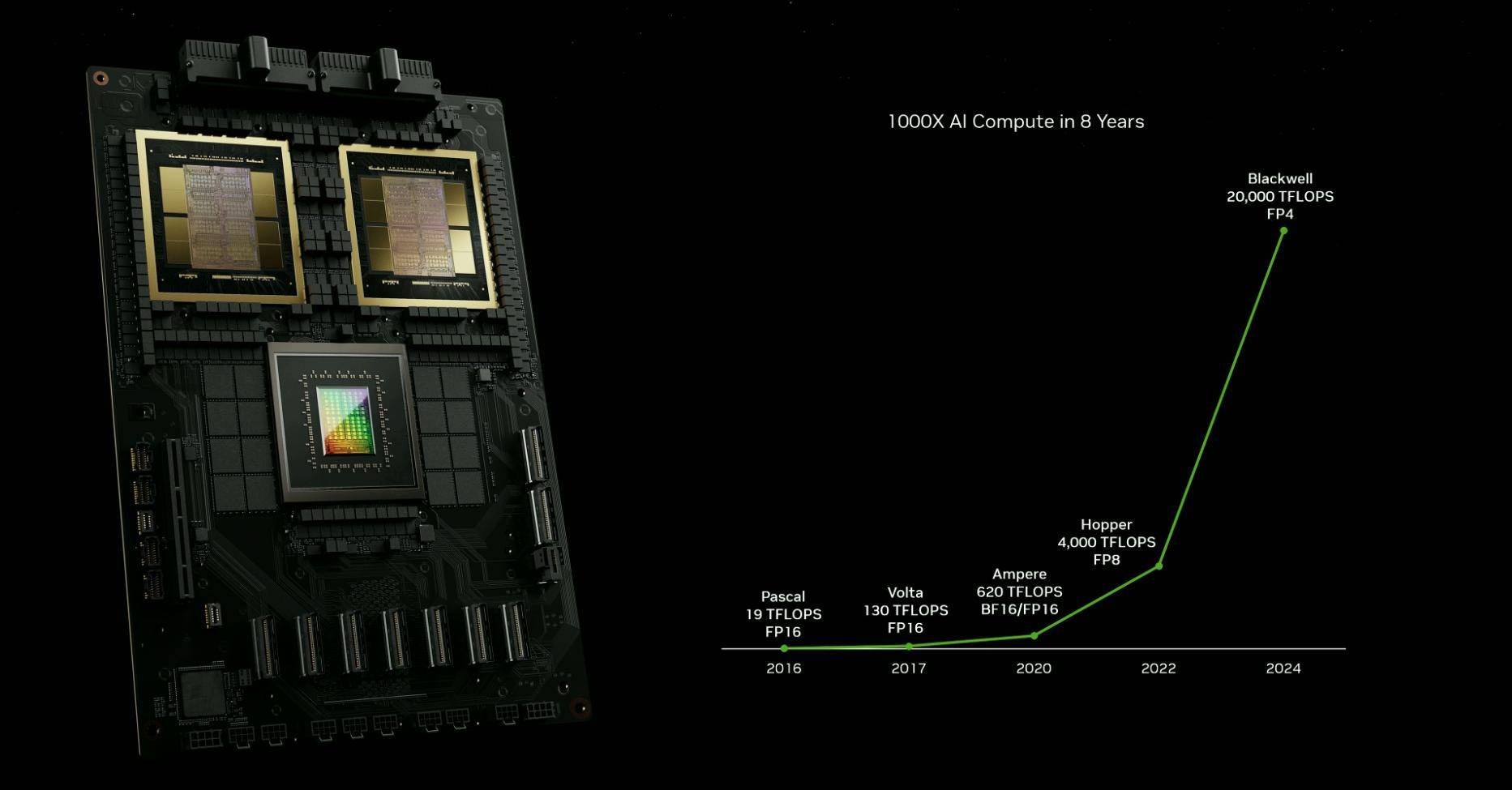

Negli ultimi 10 anni, NVIDIA ha fatto avanzare l'intelligenza artificiale circa un milione di volte, superando di gran lunga la legge di Moore: in altre parole, NVIDIA sta scrivendo la propria legge di iterazione. Dalla potenza di calcolo dei chip all'implementazione dell'intelligenza artificiale, dalla produzione automobilistica alla logistica medica, NVIDIA ha promosso lo sviluppo di vari settori compiendo al contempo i propri progressi.

La Legge di Moore è morta, ma NVIDIA ha dato vita a una nuova Legge di Moore.

Ad eccezione delle schede grafiche per computer, NVIDIA è raramente percepita da noi in tempi normali, ma il progresso tecnologico di molti prodotti che ci circondano è sempre inseparabile da essi. Dopo aver letto questo primo riassunto delle GTC 2024, forse potrai avere una percezione più ovvia del ondata dell’AIGC.

Un tweet inviato ieri sera dal CEO di OpenAI Sam Altman su X potrebbe essere una nota a piè di pagina dei tempi:

Questo è l'anno più interessante della storia umana, ad eccezione di tutti gli anni futuri

Questo è stato l’anno più interessante della storia umana, ma sarà l’anno più noioso in futuro.

Nasce il chip AI più potente del mondo e le sue prestazioni aumentano vertiginosamente

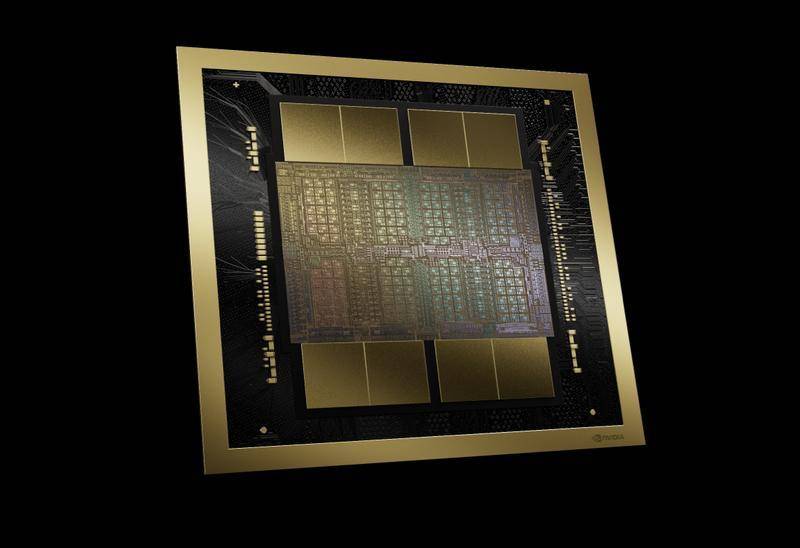

Questa è la GPU più avanzata attualmente in produzione al mondo.

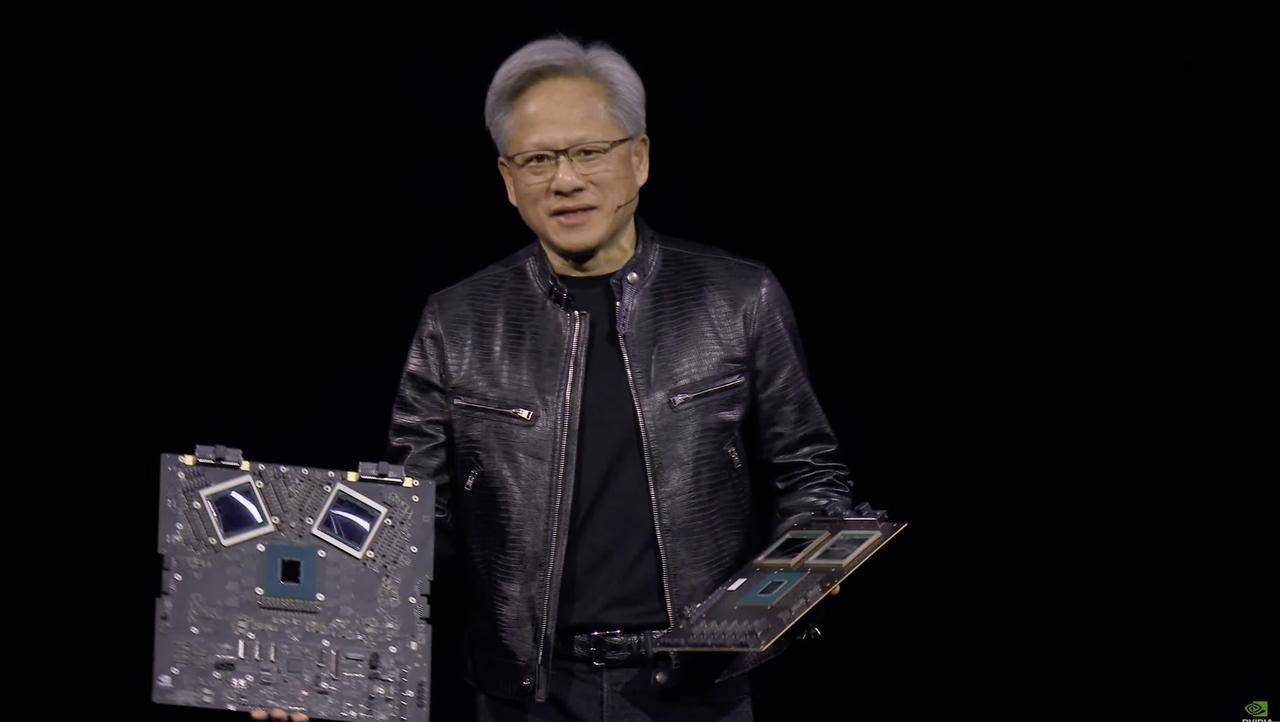

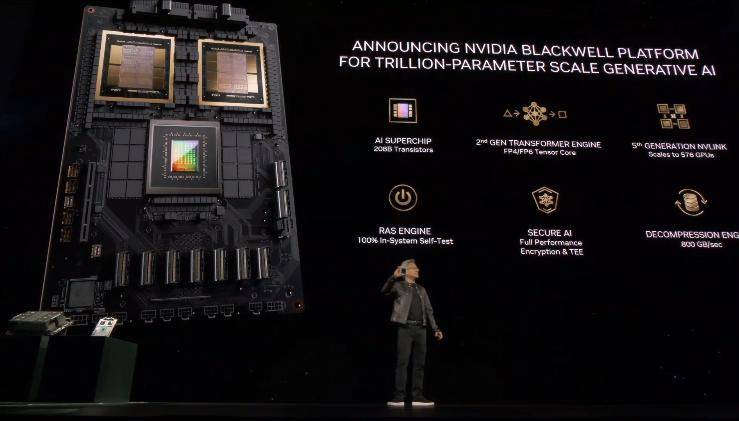

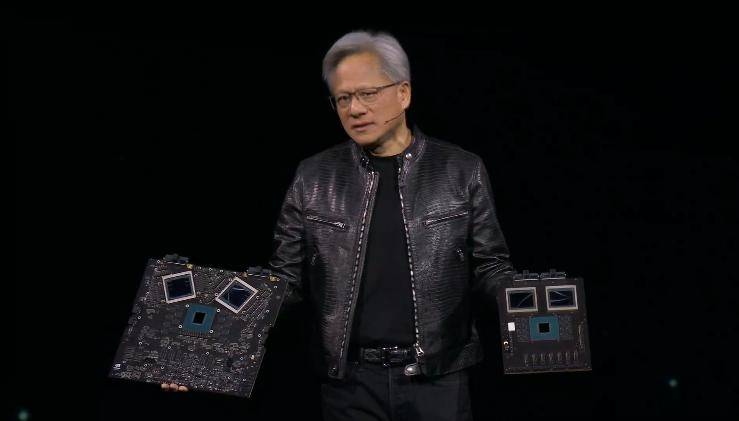

Il protagonista della conferenza stampa è il chip AI "Blackwell B200". Huang Renxun ha detto che il nome di questo chip deriva dal matematico, teorico dei giochi e teorico della probabilità David Blackwell.

Basato sul processo 4NP di TSMC, il chip di calcolo sotto l'architettura Blackwell ha 104 miliardi di transistor, un altro passo avanti rispetto agli 80 miliardi di transistor della GPU GH100 della generazione precedente.

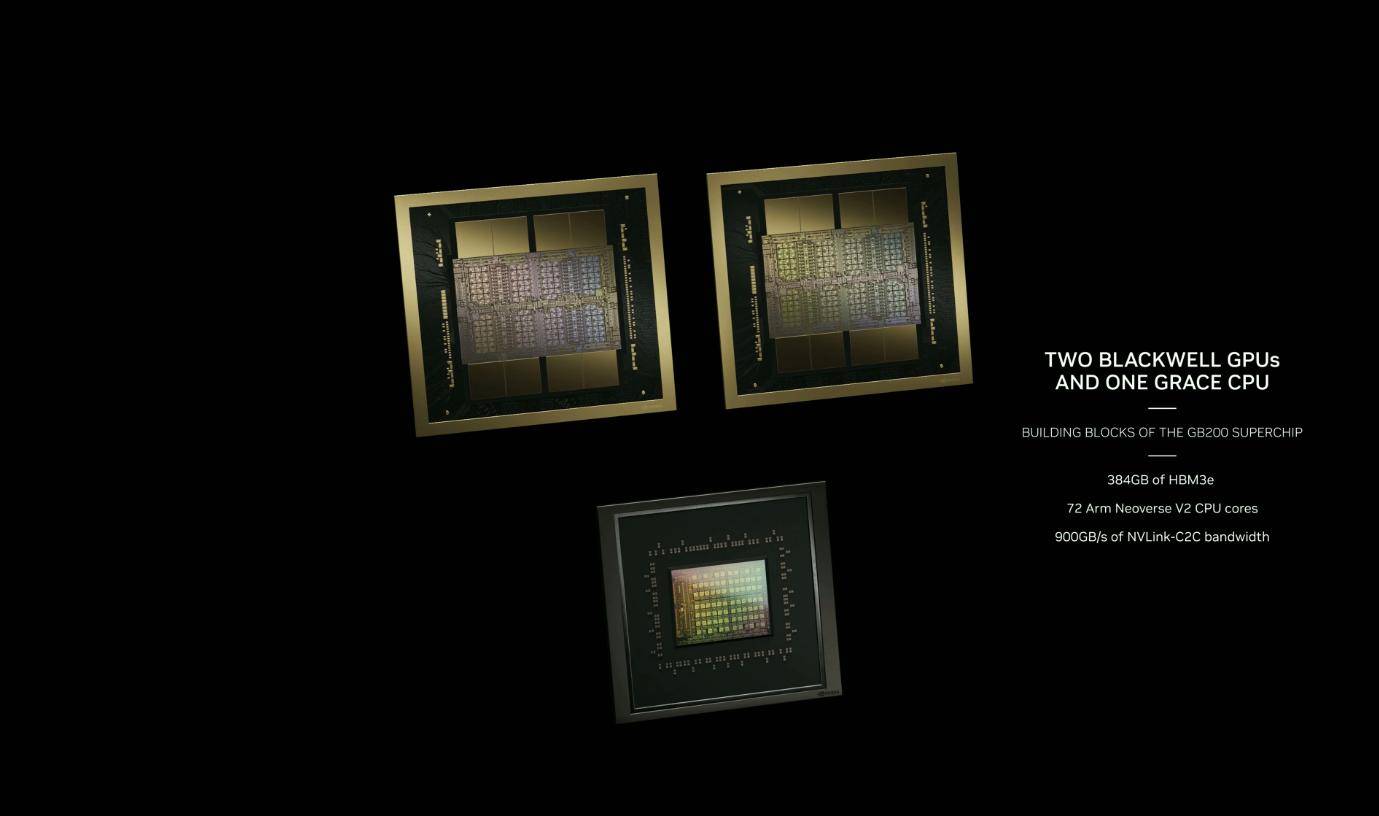

Blackwell B200 non è una GPU singola nel senso tradizionale: è composta da due GPU Blackwell + un chip CPU Grace ed è collegata tramite NV-HBI (Nvidia High Bandwidth Interface) da 10 TB/s per garantire che ciascun chip possa funzionare da solo .

Pertanto, il B200 ha in realtà 208 miliardi di transistor e può fornire fino a 20 petaflop di potenza di calcolo FP4.Le due GPU combinate con un'unica CPU Grace possono aumentare di 30 volte l'efficienza del lavoro di inferenza LLM (Large Language Model).

Anche le prestazioni di GB200 saranno notevolmente migliorate: nel benchmark GPT-3 LLM con 175 miliardi di parametri, le prestazioni di GB200 sono 7 volte quelle di H100 e la sua velocità di allenamento è 4 volte quella di H100.

Inoltre, riduce i costi e il consumo energetico di 25 volte rispetto all'H100.

In precedenza, sebbene il processore AI H100 di NVIDIA fosse molto popolare, il consumo energetico di picco di ciascun H100 raggiungeva i 700 watt, superando il consumo energetico medio delle normali famiglie americane. Gli esperti prevedono che, man mano che viene utilizzato un gran numero di H100, la loro potenza totale il consumo sarà pari a quello di una grande città americana paragonabile, o addirittura più grande, ad alcuni piccoli paesi europei.

Huang Renxun ha affermato che l'addestramento di un modello da 1,8 trilioni di parametri prima richiedeva 8.000 GPU Hopper e 15 megawatt di potenza, mentre ora 2.000 GPU Blackwell possono farlo con solo 4 megawatt di consumo energetico.

Le potenti prestazioni della GPU Blackwell B200 si riflettono perfettamente anche in termini di consumo energetico. Il B200, che utilizza la più recente tecnologia di interconnessione NVLink, supporta la stessa architettura 8GPU e switch di rete 400GbE. Sebbene le sue prestazioni siano notevolmente migliorate, può raggiungere lo stesso picco di consumo energetico (700 W) della generazione precedente H100/H200.

Un altro punto degno di nota è la potenza di calcolo del 4PQ. Huang Renxun ha affermato che negli ultimi otto anni la potenza di calcolo dell'intelligenza artificiale è aumentata di mille volte. Il miglioramento più critico è il motore Transformer di seconda generazione, che ha migliorato significativamente il calcolo, la larghezza di banda e le dimensioni del modello attraverso la potenza di calcolo dell'FP4.

Rispetto alla potenza di calcolo FP8 comunemente utilizzata nell'intelligenza artificiale, i due chip di calcolo del B200 rendono le sue prestazioni 2,5 volte superiori a quelle dell'H100.La potenza di calcolo di ciascun chip con l'architettura Blackwell è superiore del 25% rispetto al chip Hopper della generazione precedente.

Lo scienziato senior di NVIDIA Jim Fan definisce la nuova GPU Blackwell B200 "una nuova bestia dalle prestazioni".

La potenza di calcolo di B200 supera 1 Exaflop all'interno di una singola architettura. Le prestazioni del primo DGX fornito a OpenAI da Jen-Hsun Huang sono di 0,17 Petaflop. I parametri GPT-4-1.8T possono essere addestrati su 2.000 unità Blackwell entro 90 giorni.

Non è esagerato affermare che è nata una nuova Legge di Moore.

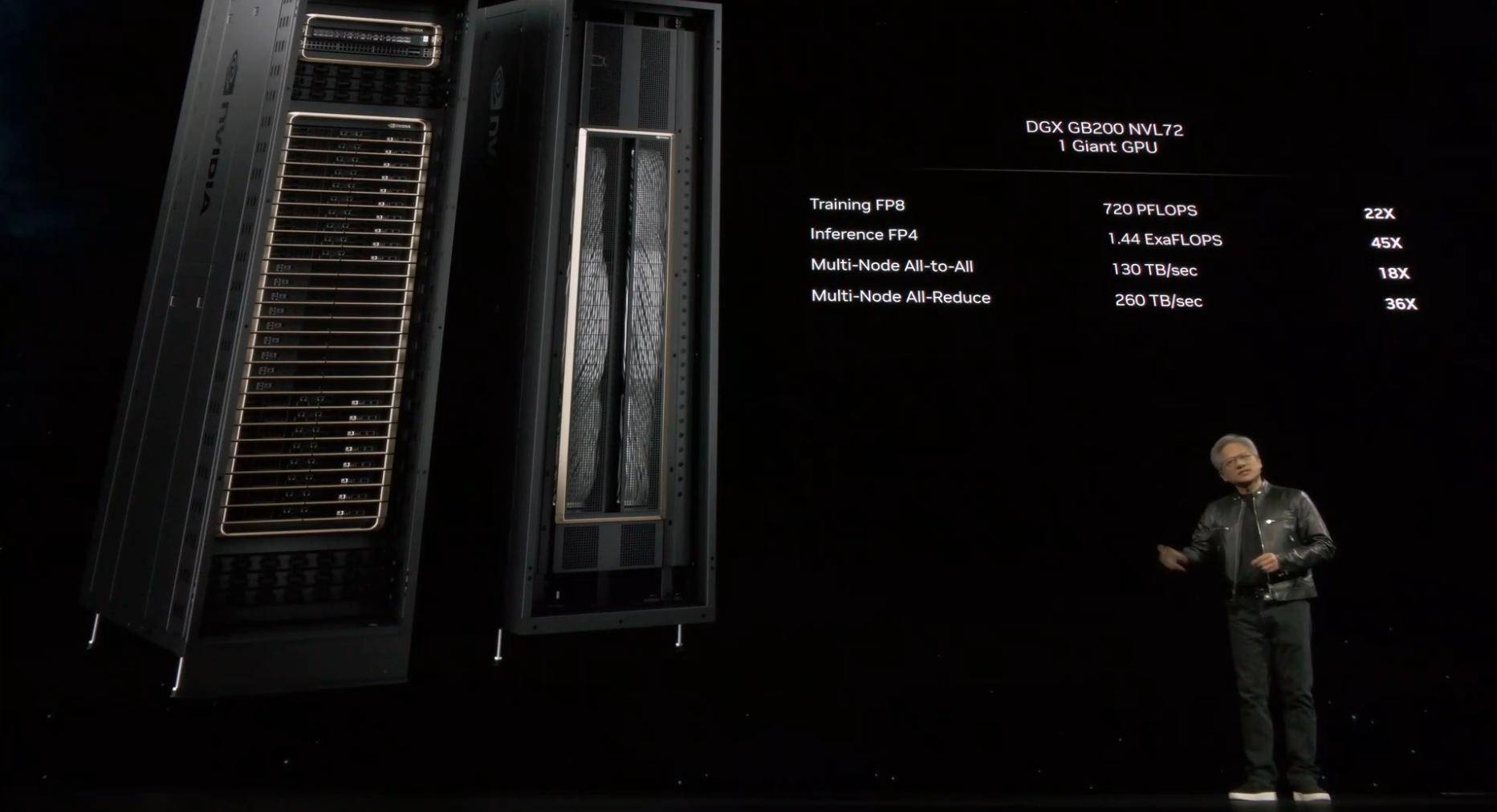

Poiché Blackwell è disponibile in diverse varianti, Nvidia fornisce anche le specifiche per l'intero nodo server, con tre opzioni principali.

Il primo è il sistema GB200 NVL72 più grande e potente, configurato con 18 server 1U, ciascun server è dotato di due super chip GB200. Il sistema fornisce 72 GPU B200 con 1440 Peta FLOPS di prestazioni di inferenza AI FP4 e 720 Peta FLOPS di prestazioni di addestramento AI FP8. Adotterà una soluzione di raffreddamento a liquido. Un NVL72 può gestire 27 trilioni di modelli di parametri (GPT-4 Il parametro massimo non superare 1,7 trilioni di parametri).

Un'altra specifica è l'HGX B200, che si basa sull'utilizzo di otto GPU B200 e una CPU x86 in un singolo nodo server. Ciascuna GPU B200 può essere configurata fino a 1000 W e la GPU fornisce fino a 18 petaflop di throughput FP4, che è più lento rispetto alla GPU del GB200 del 10%.

Infine, NVIDIA lancerà anche l'HGX B100, che ha le stesse specifiche generali dell'HGX B200, dotato di CPU x86 e 8 GPU B100, ma sarà direttamente compatibile con l'infrastruttura HGX H100 esistente e consentirà l'implementazione più rapida delle GPU Blackwell , ciascuno Il TDP della GPU è limitato a 700 W.

In precedenza, Nvidia è diventata un'azienda multimiliardaria grazie ai chip AI come H100 e H200, superando aziende leader come Amazon. La nuova GPU Blackwell B200 e il "super chip" GB200 rilasciati oggi sono molto promettenti. Potrebbe estendersi è in vantaggio e supera addirittura Apple.

L’era del software che definisce tutto sta arrivando

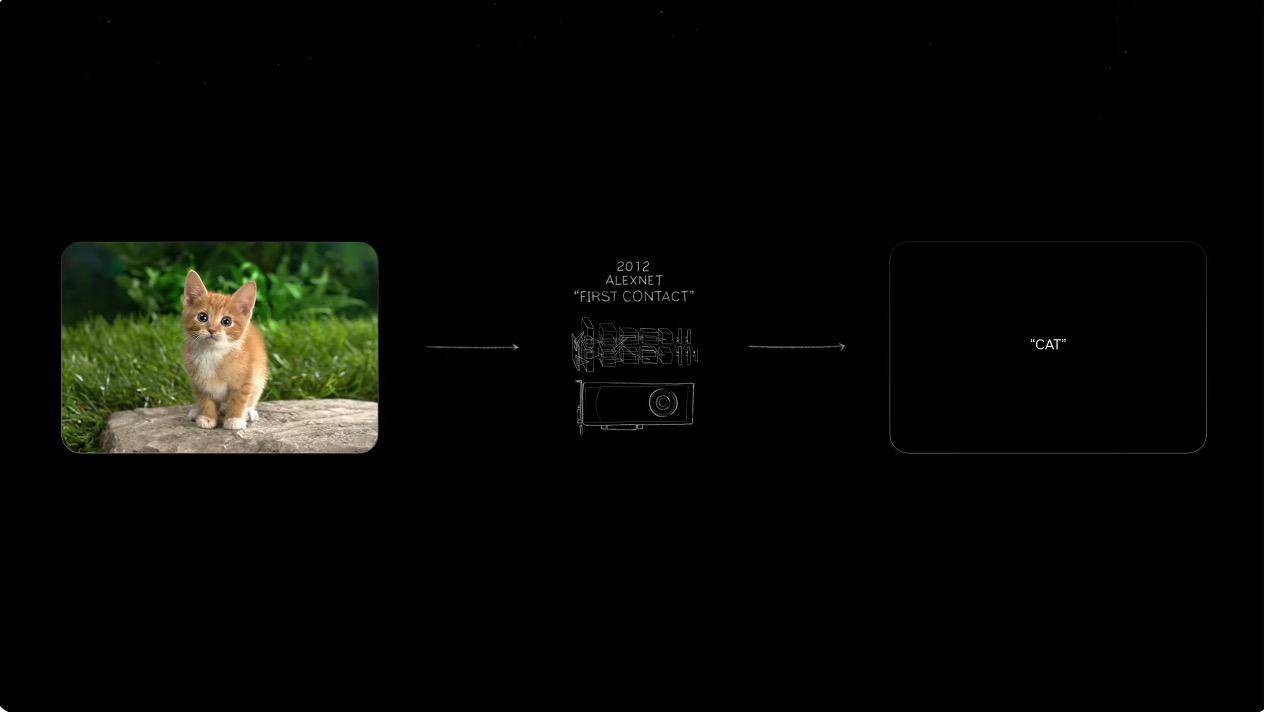

Nel 2012, un piccolo gruppo di ricercatori ha rilasciato un rivoluzionario sistema di riconoscimento delle immagini chiamato AlexNet, che all’epoca surclassava di gran lunga i metodi precedenti nel compito di classificare cani e gatti, rendendolo leader nel deep learning e nelle reti neurali convoluzionali. il potenziale della (CNN) nel riconoscimento delle immagini.

È stato proprio dopo aver visto le opportunità dell’IA che Huang Renxun ha deciso di scommettere tutto sull’IA. La cosa interessante è che in passato veniva utilizzato per riconoscere le immagini generate e generare testo, ma ora serve per generare immagini attraverso il testo.

Quindi, quando arriverà l’ondata dell’intelligenza artificiale generativa, cosa possiamo farne? Jen-Hsun Huang ha dato alcune risposte standard.

I modelli meteorologici tradizionali combinati con il modello meteorologico Cordiff di NVIDIA possono ottenere previsioni che esplorano aree di centinaia o addirittura migliaia di chilometri, fornendo la gamma di impatti come i tifoni, riducendo così al minimo le perdite di proprietà. Cordiff sarà aperto anche a più paesi e regioni in futuro.

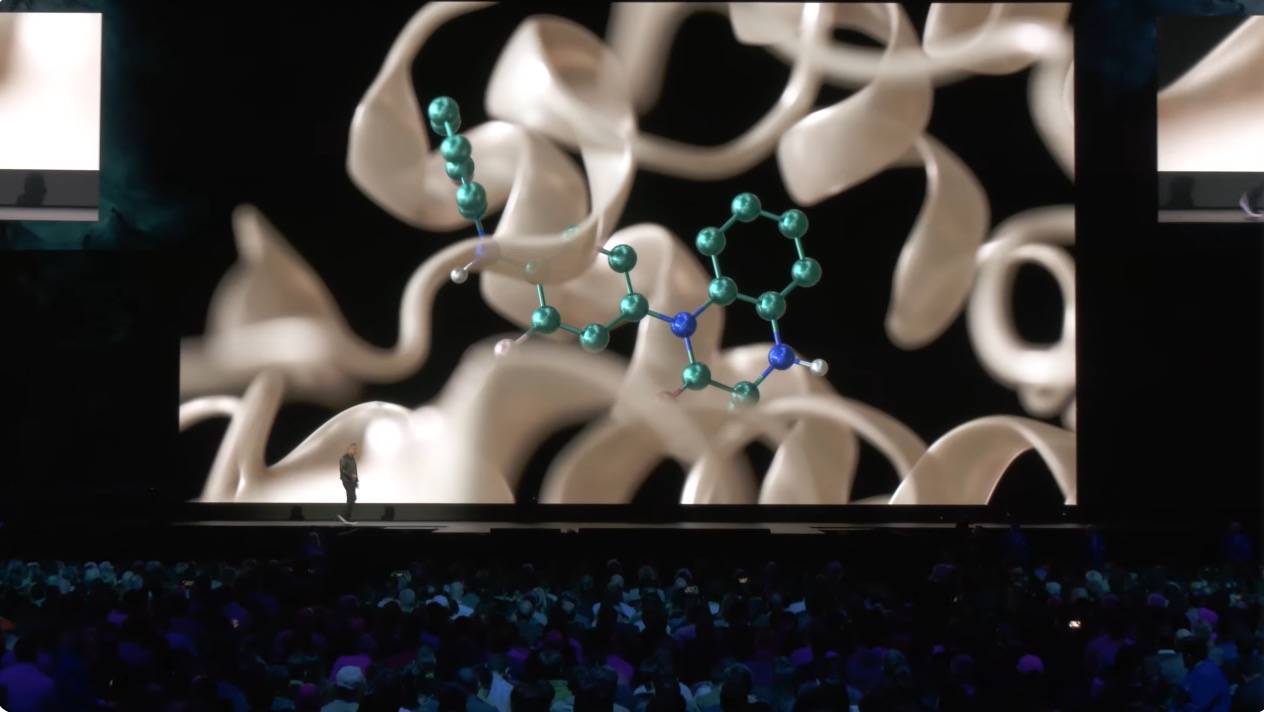

L’intelligenza artificiale generativa non solo è in grado di comprendere immagini e audio attraverso funzionalità digitali, ma può anche utilizzare la sua enorme potenza di calcolo per scansionare miliardi di composti per individuare nuovi farmaci.

In qualità di trafficante di armi IA, Huang Renxun ha anche introdotto il sistema NiMS, specializzato nell'assistenza allo sviluppo di chip IA. In futuro potresti anche avere l'opportunità di formare un super team di IA: dopo aver suddiviso l'attività in una serie di sottoattività, potrai lasciare che diverse IA completino compiti come il recupero e l'ottimizzazione del software.

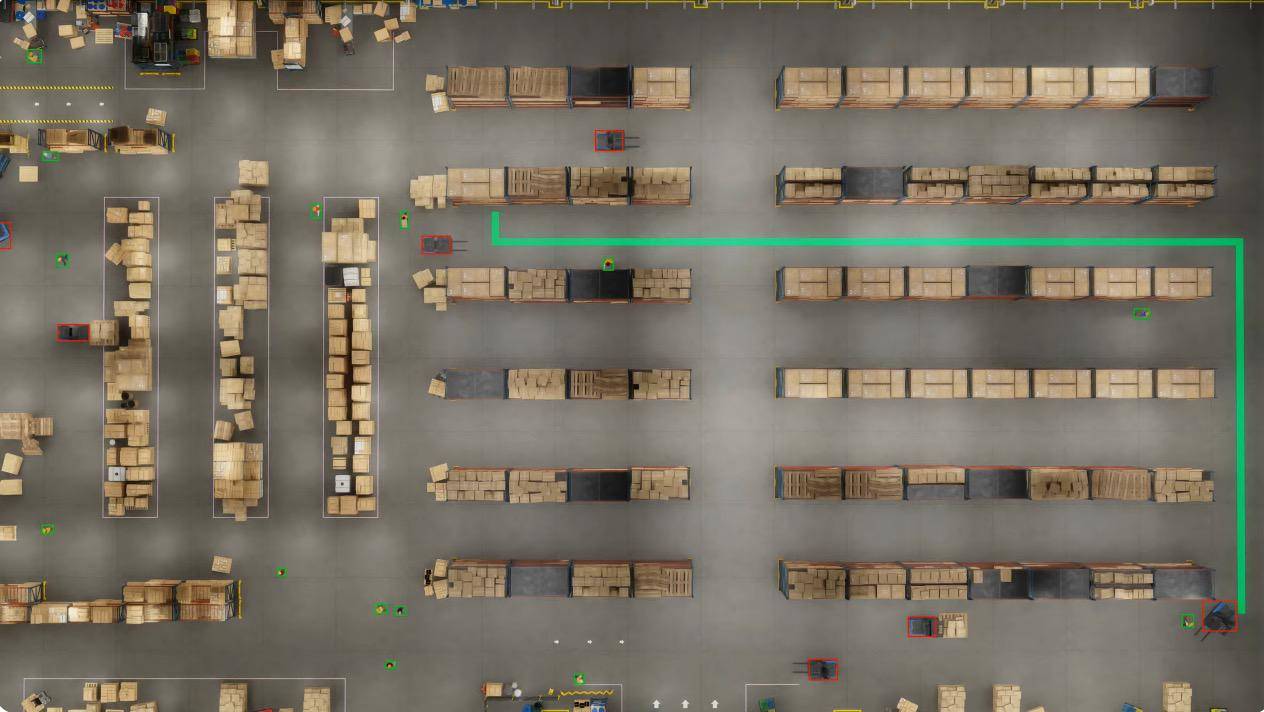

Le strutture, i magazzini e gli stabilimenti del futuro saranno definiti dal software.

Che si tratti di robot umanoidi, automobili a guida autonoma o bracci manipolatori, questi robot autonomi richiedono sistemi operativi a livello di software. Ad esempio, attraverso la combinazione di AI e Omniverse, NVIDIA ha costruito un magazzino robotizzato che copre un’area di 100.000 metri quadrati.

In questo ambiente simulato fisicamente accurato, 100 telecamere montate a soffitto mappano tutte le attività nel magazzino in tempo reale utilizzando il software NVIDIA Metropolis e le capacità di pianificazione del percorso dei robot mobili autonomi (AMR).

Queste simulazioni includono anche test in loop del software dell'agente AI per valutare e ottimizzare la capacità del sistema di adattarsi all'imprevedibilità del mondo reale.

In uno scenario simulato, l'AMR ha riscontrato un incidente mentre andava a prelevare un pallet, bloccando il percorso previsto. Nvidia Metropolis ha quindi aggiornato e inviato una mappa di occupazione in tempo reale al sistema di controllo, che ha calcolato il nuovo percorso ottimale.

Gli operatori del magazzino possono anche porre domande al modello visivo attraverso il linguaggio naturale e il modello può comprendere dettagli e attività e fornire un feedback immediato per migliorare l'efficienza operativa.

Vale la pena ricordare che a questa conferenza è apparso anche Apple Vision Pro. Le aziende possono facilmente trasmettere in streaming descrizioni interattive di scene universali (OpenUSD) di applicazioni 3D a Vision Pro in tempo reale tramite Omniverse Cloud, aiutando gli utenti a esplorare mondi virtuali come mai prima d'ora.

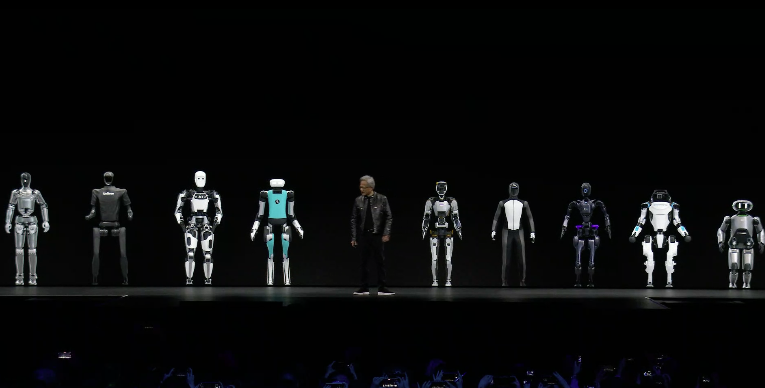

La fine della conferenza stampa è stata il familiare segmento dei robot. Come ha detto Huang Renxun, nel momento in cui ha aperto le mani e si è messo in piedi con altri robot umanoidi, in questo momento, "l'intersezione tra computer grafica, fisica e intelligenza artificiale, questo… Tutto inizia in questo momento.”

▲ Piccolo uovo di Pasqua

Dieci anni fa al GTC Jen-Hsun Huang sottolineò per primo l'importanza dell'apprendimento automatico: mentre molti consideravano Nvidia ancora come un produttore di "schede grafiche per giochi", Nvidia era già in prima linea nella rivoluzione dell'intelligenza artificiale.

Nel 2024, noto come il primo anno delle applicazioni IA, NVIDIA ha già utilizzato software e hardware IA per potenziare vari settori in molti campi: modelli linguistici di grandi dimensioni, IA conversazionale, edge computing, big data, guida autonoma, robot bionici…

La scoperta di farmaci non è la nostra competenza, lo è l’informatica; costruire automobili non è la nostra competenza, lo sono i computer IA necessari per costruire automobili. Francamente, è difficile per un'azienda essere brava in tutte queste cose, ma noi siamo molto bravi nella parte relativa all'informatica.

Rispetto al leader in un singolo settore, NVIDIA è più simile a un "grande uomo dietro le quinte." Finché si parla di intelligenza artificiale, NVIDIA deve essere un argomento inevitabile.

Come ha detto Huang, NVIDIA è già una società di piattaforme.

Sono stati l'implementazione anticipata e la tendenza generale dello sviluppo storico che hanno permesso a Nvidia di occupare più del 70% delle vendite del mercato dei chip AI all'inizio dell'era dell'intelligenza artificiale, e la valutazione dell'azienda ha superato anche i 2 trilioni di dollari. molto tempo fa.

Forse è anche questo il motivo per cui Apple, dopo aver lottato per molti anni, ha rinunciato a costruire automobili e ha investito molto nell’intelligenza artificiale generativa: che si tratti di vantaggi economici o di tendenze tecnologiche, è troppo degna di una scommessa.

In un momento in cui stiamo ancora mettendo in discussione l'utilità dell'"intelligenza artificiale", NVIDIA ha dimostrato con le azioni che l'intelligenza artificiale è diventata una parte indispensabile della nuova era.

Autore: Li Chaofan, Xiao Fanbo, Mo Chongyu

# Benvenuti a seguire l'account pubblico WeChat ufficiale di aifaner: aifaner (ID WeChat: ifanr). Contenuti più interessanti ti verranno forniti il prima possibile.

Ai Faner | Link originale · Visualizza commenti · Sina Weibo